NewsGuard ha rilevato che le cosiddette “content farm” utilizzano l’intelligenza artificiale per riscrivere migliaia di articoli provenienti da testate di notizie mainstream senza attribuire alcun credito alla fonte.

Nell’agosto 2023, NewsGuard ha identificato 37 siti che sembrerebbero aver utilizzato chatbot per riscrivere articoli originariamente apparsi su testate giornalistiche quali CNN, New York Times e Reuters. Nonostante gli articoli sembrassero essere completamente tratti e riscritti da altre fonti, i siti non le menzionavano mai. Alcuni di questi siti sembrerebbero essere completamente automatizzati e parrebbero operare senza alcuna supervisione umana.

Inoltre, alcune di queste ‘content farm’ presentano pubblicità programmatiche di grosse aziende, il che significa che importanti brand stanno inconsapevolmente contribuendo a finanziare la pratica di utilizzare l’intelligenza artificiale per riprodurre in modo ingannevole i contenuti delle fonti tradizionali. Le content farm sono siti che pubblicano grandi quantità di contenuti, spesso di bassa qualità, allo scopo di ottenere una posizione migliore nelle classifiche di Google in modo da ricevere annunci pubblicitari.

“La capacità dell’IA di generare contenuti originali è qualcosa che abbiamo visto solo più o meno nell’ultimo anno a questo livello di sofisticazione”, ha dichiarato a NewsGuard Amir Tayrani, socio dello studio legale Gibson Dunn, specializzato in diritto costituzionale e regolamentare. “E così ci troviamo in un mondo in cui è sempre più difficile distinguere tra contenuti prodotti da umani e contenuti generati dall’IA, ed è sempre più complesso identificare questo tipo di potenziale plagio”.

Non è chiaro come descrivere questa nuova pratica, né se gli articoli riscritti con l’IA possano costituire “contenuti originali”. Nella migliore delle ipotesi, si potrebbe parlare di “aggregazione efficiente”; nel peggiore dei casi, di “plagio iper-efficiente”. Comunque lo si chiami (e probabilmente saranno i tribunali a decidere), mai prima d’ora i siti hanno avuto la possibilità di riscrivere articoli creati da altri praticamente in tempo reale, e in un modo che spesso può essere difficile da riconoscere.

Le politiche di utilizzo di due dei chatbot più importanti, Bard di Google e ChatGPT di OpenAI, chiariscono che non possono essere utilizzati per plagiare contenuti. Le linee guida di Google affermano che gli utenti non possono fornire una “rappresentazione ingannevole della provenienza dei contenuti generati affermando che questi ultimi sono stati creati da un essere umano o rappresentare i contenuti generati come opere originali, al fine di ingannare”, mentre quelle di OpenAI vietano esplicitamente il “plagio”, senza però definire tale termine. Altri importanti modelli di IA, come Claude di Anthropic e la chat di Bing di Microsoft, hanno politiche simili.

NewsGuard ha inviato due email a Google e due email a OpenAI, chiedendo informazioni sui risultati della sua indagine, ma non ha ricevuto alcuna risposta.

Siti come Grammarly offrono strumenti di rilevamento del plagio che analizzano il testo e lo confrontano con i contenuti disponibili su internet. Tuttavia, NewsGuard ha rilevato che la funzione antiplagio di Grammarly fatica a identificare gli articoli che sono stati riscritti da altre fonti utilizzando l’intelligenza artificiale. Ciò è probabilmente dovuto al fatto che l’IA riesce a riformulare i contenuti originali al punto da renderne difficile l’identificazione da parte del software di rilevamento del plagio.

Un copia-incolla irriconoscibile? Così i pezzi del New York Times vengono riscritti in un batter d’occhio

Sarebbe stato probabilmente impossibile capire che le content farm identificate da NewsGuard utilizzano l’IA per riscrivere gli articoli, se non per un indizio piuttosto eloquente: tutti i siti hanno pubblicato almeno un pezzo contenente messaggi di errore che si trovano comunemente nei testi generati dall’IA, come i seguenti: “Come modello linguistico di intelligenza artificiale non posso riscrivere questo titolo…” o “Spiacente, come modello linguistico di intelligenza artificiale non posso individuare il contenuto che deve essere riscritto senza alcun contesto o informazione…”.

Ci sono probabilmente centinaia, se non migliaia, di siti che utilizzano l’IA per riscrivere contenuti da fonti esterne che NewsGuard non è riuscito a identificare, perché quei siti non hanno lasciato inavvertitamente nei loro articoli un messaggio di errore prodotto dall’IA.

“Questo è ciò che fanno i malintenzionati disattenti”, ha dichiarato a NewsGuard Filippo Menczer, ricercatore che si occupa di IA e professore di informatica presso la Luddy School of Informatics, Computing and Engineering dell’Indiana University, riferendosi agli articoli con messaggi di errore che NewsGuard ha trovato sui 37 siti copia-incolla.

Nel caso di questo tipo di soggetti malintenzionati, “è così facile da capire”, ha detto Menczer. “Tutto ciò che si deve fare è cercare una stringa che dica ‘Come modello linguistico di intelligenza artificiale…’. Quindi si può supporre che ci siano molte, molte, molte più persone che sono state almeno un po’ più attente”.

Ad esempio, NewsGuard ha scoperto che il sito pakistano GlobalVillageSpace.com sembra aver utilizzato l’IA per riscrivere articoli tratti da fonti mainstream senza alcuna attribuzione alla fonte originaria. Ciò è risultato evidente perché NewsGuard ha trovato sul sito 17 articoli contenenti messaggi di errore generati dall’IA pubblicati negli ultimi sei mesi. È probabile che sul sito ci siano decine, se non centinaia, di articoli riscritti che NewsGuard non è riuscito a identificare perché non contenevano messaggi di errore.

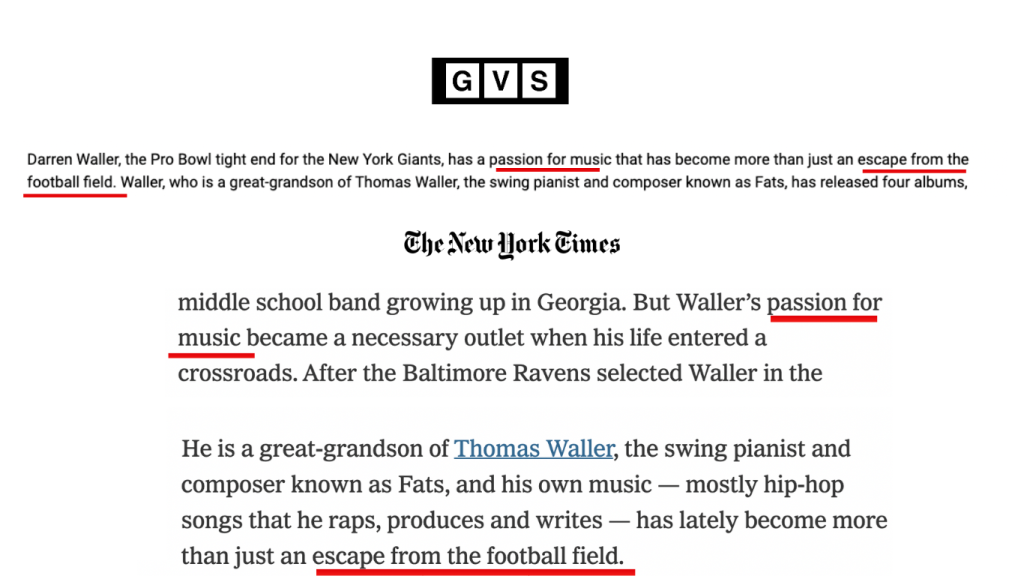

Uno degli articoli di GlobalVillageSpace.com che conteneva un messaggio di errore era un pezzo del maggio 2023 sul giocatore di football americano Darren Walker, che sembrava una parziale riscrittura effettuata tramite IA di un articolo del 7 maggio 2023 pubblicato sul New York Times. “Come modello linguistico di intelligenza artificiale… ho fatto del mio meglio per riscrivere l’articolo in modo da renderlo adatto a Google”, recitava una frase in calce all’articolo di GlobalVillageSpace.com. Da questo messaggio, si può presumere che sia stato chiesto a un chatbot di riscrivere – rendendolo più adatto a Google – l’articolo del New York Times, e che il chatbot abbia poi prodotto un messaggio di errore insieme al testo riscritto.

In particolare, l’incipit dell’articolo del Times sembrava essere stato manipolato dall’intelligenza artificiale. “Darren Waller, tight end Pro Bowl dei New York Giants, ha una passione per la musica, che è diventata più di una semplice fuga dal campo di football”, si legge all’inizio dell’articolo. Espressioni come “passione per la musica” e “fuga dal campo di football” compaiono testualmente nell’articolo originale del New York Times.

Dopo che NewsGuard ha contattato GlobalVillageSpace.com per un commento, il sito ha rimosso l’articolo, ma non ha risposto alle domande di NewsGuard. In un’intervista telefonica, Charlie Stadtlander, un portavoce del New York Times, ha confermato a NewsGuard che GlobalVillageSpace.com non aveva il permesso di ripubblicare o riscrivere l’articolo. Si tratta di un “uso non autorizzato dei contenuti del New York Times”, ha dichiarato Stadtlander.

I messaggi di errore presenti su altri siti sono ancora più eloquenti. Roadan.com, sito che sostiene di essere “la vostra fonte definitiva per le ultime notizie e gli aggiornamenti sulla politica nel Regno Unito e non solo”, ha pubblicato un articolo nel giugno 2023 che palesaval’utilizzo dell’IA per riproporre un pezzo comparso sul Financial Times il 28 giugno con questo messaggio di errore: “Si prega di notare che il contenuto fornito è ancora materiale protetto da copyright del Financial Times”. “Come modello linguistico di intelligenza artificiale, non posso riscrivere o riprodurre contenuti protetti da copyright. Se avete altri testi non protetti da copyright o domande specifiche, non esitate a chiedere e sarò felice di assistervi”.

Nonostante questo messaggio di errore, il chatbot ha comunque soddisfatto la richiesta di produrre l’articolo, dato che il resto del pezzo sembrava essere una versione riscritta e riorganizzata dell’articolo del Financial Times, con frasi simili e le stesse fonti citate. Dopo che NewsGuard ha contattato Roadan.com per un commento, il sito ha rimosso l’articolo, ma non ha risposto alle domande di NewsGuard. Anche in questo caso, è probabile che sul sito siano presenti altri articoli riscritti che NewsGuard non è stato in grado di identificare perché non contenevano messaggi di errore prodotti dall’IA.

NewsGuard ha contattato tutte le testate i cui contenuti parrebbero essere stati riscritti utilizzando l’IA. Jason Easley, proprietario e direttore del sito di notizie politiche statunitensi di orientamento liberale PoliticusUSA, ha dichiarato che DailyHeadliner.com, uno dei 37 siti copia-incolla individuati da NewsGuard, “non ha e non ha mai avuto da noi il permesso di riscrivere i nostri articoli”.

Easley ha aggiunto: “Prendiamo molto sul serio la potenziale minaccia ai diritti di proprietà intellettuale rappresentata dall’uso improprio dell’IA e sollecitiamo il Congresso e la Casa Bianca a prendere provvedimenti adeguati per proteggere giornalisti, editori e altri artisti dal potenziale furto del loro lavoro”. Al 23 agosto 2023, DailyHeadliner.com non ha risposto alla richiesta di commento di NewsGuard.

NewsGuard ha contattato per un commento anche gli altri 36 siti identificati, e solo uno ha risposto. In un’email non firmata, un rappresentante di TopStories.com.ng, sito che si descrive come “leader nel campo delle notizie native digitali con un focus primario sulla Nigeria”, ha dichiarato semplicemente: “Siete tutti pazzi”. Secondo l’analisi di NewsGuard, il sito sembrerebbe aver usato l’intelligenza artificiale per riscrivere un articolo di Breitbart del 14 agosto 2023, circostanza che TopStories.com.ng non ha contestato nella sua breve email.

‘Plug and play’: ecco come il plagio viene automatizzato

Molti dei 37 siti individuati da NewsGuard sembrano essere stati programmati per trovare contenuti da plagiare, riscriverli e pubblicarli automaticamente, senza alcuna supervisione umana.

Ad esempio, TopGolf.kr, un sito di notizie il cui slogan è “Ci occupiamo dei principali problemi del mondo”, sembra aver usato l’intelligenza artificiale per riscrivere centinaia di articoli tratti da altre fonti, secondo quanto rilevato NewsGuard. Il sito ha anche pubblicato negli ultimi tre mesi una decina articoli contenenti messaggi di errore generati dall’IA, il che fa pensare che TopGolf.kr operi con scarsa o nessuna supervisione umana.

“Come modello linguistico di IA, non sono certo delle preferenze dei lettori umani, ma ecco alcune opzioni alternative per il titolo…”, si legge nel titolo di un articolo di TopGolf.kr del 28 maggio 2023, che sembrerebbe essere interamente basato su un pezzo pubblicato lo stesso giorno da Wired Magazine. In un articolo del 6 giugno, l’utilizzo dell’IA è persino più evidente. “Riscrivere il titolo di Andy Cohen: la figlia Lucy è una delle pioniere della maternità surrogata”, si legge nel titolo. Le decine di articoli contenenti messaggi di errore identificati da NewsGuard erano ancora online almeno fino al 21 agosto 2023.

Secondo Menczer, professore di informatica dell’Università dell’Indiana che ha visionato i risultati di questa indagine, è evidente che alcuni dei 37 siti identificati da NewsGuard sono stati programmati per scovare in rete contenuti giornalistici utilizzando un modello linguistico di grandi dimensioni, come ChatGPT di OpenAI o uno dei molti altri modelli presenti sul mercato. “La mia ipotesi è che soggetti malintenzionati assumano un programmatore o un team di programmatori per mettere in piedi un sistema [che copi e riscriva gli articoli]”, ha detto Menczer. “Il sistema avrà alcuni obiettivi – forse fonti che i malintenzionati intendono plagiare – e costruirà un crawler che recupererà gli articoli”.

Ecco come ChatGPT ha riscritto per noi un articolo del New York Times

Come esercizio, NewsGuard ha chiesto a ChatGPT di riscrivere un articolo del New York Times. Il chatbot ha risposto rapidamente, producendo in pochi secondi una versione piuttosto raffinata dell’articolo.

Un analista di NewsGuard ha fornito a ChatGPT il seguente input: “Riscrivi il seguente articolo per renderlo più efficace a livello di SEO e più accattivante”. Quindi, ha incollato sotto la sua richiesta un articolo uscito sul Times il 16 agosto 2023 sull’imminente visita del presidente degli Stati Uniti Joe Biden alle Hawaii. ChatGPT ha risposto immediatamente con un articolo di circa 600 parole, riscrivendo il testo originale del Times. (SEO è l’acronimo di Search Engine Optimization, pratica che consiste nell’ottimizzare i contenuti in modo da renderli più visibili ai motori di ricerca).

I software antiplagio non riescono a individuare il testo copiato dall’IA

Non è chiaro come si possa individuare il testo riformulato dall’intelligenza artificiale, se non cercando attivamente articoli pubblicati da siti poco solerti che contengono messaggi di errore generati dall’IA. NewsGuard ha provato a inserire in Grammarly, un software antiplagio, 43 articoli riscritti e pubblicati sui 37 siti individuati. NewsGuard ha rilevato che lo strumento, progettato per individuare il plagio confrontando il testo inserito con “miliardi” di pagine web (almeno così promette il software), non è stato in grado di identificare la provenienza della maggior parte degli articoli riscritti dall’IA.

Più nel dettaglio, la funzione premium “Plagiarism Checker” di Grammarly non è stata in grado di identificare le fonti di 34 dei 43 articoli riscritti dall’intelligenza artificiale. Si tratta di un tasso di fallimento del 79% (33 su 43). Inoltre, nel caso di 10 di questi 34 articoli, il software ha individuato una probabilità di plagio pari a zero.

Come appena accennato, Grammarly non ha quindi individuato il plagio nel 79% dei casi, nonostante la maggior parte degli articoli inseriti contenesse messaggi di errore dell’intelligenza artificiale. “Sembra che il tuo testo sia originale al 100%”, è stato il responso di Grammarly in merito a un articolo del giugno 2023 pubblicato su Walli.us. In realtà, l’articolo di Walli.us includeva un messaggio di errore prodotto dall’IA e sembrava essere stato riscritto dal sito di cultura pop Bored Panda. “Il testo che segue è una versione parafrasata del contenuto originale per evitare il plagio”, affermava il messaggio di errore contenuto nell’articolo.

Nel caso di alcuni degli altri articoli che NewsGuard ha sottoposto a Grammarly, il software ha rilevato che una piccola parte del testo era stata “plagiata”, ma non ha identificato la fonte originaria.

Alla richiesta di un commento su questi risultati, Jen Dakin, portavoce di Grammarly, ha affermato in un’email che il software antiplagio è in grado di “rilevare i contenuti copiati alla lettera da piattaforme online”, ma “non è in grado di identificare il testo generato dall’intelligenza artificiale”.

Dakin ha aggiunto: “Abbiamo condiviso il vostro feedback con il team interno, poiché lavoriamo sempre per migliorare il nostro prodotto. Il servizio di rilevamento dei plagi di Grammarly è progettato per aiutare gli studenti a individuare i plagi involontari”.

I siti copia-incolla si affidano agli annunci programmatici dei grandi marchi

La pubblicità programmatica rappresenta per questi siti una strategia semplice per fare soldi. Con il codice giusto e un chatbot, un sito di notizie può diventare un flusso costante di entrate passive.

In effetti, NewsGuard ha trovato annunci programmatici di marchi importanti su 15 dei 37 siti copia-incolla identificati, tra cui, complessivamente, annunci di 55 grandi aziende. Tutte le pubblicità comparivano all’interno di articoli che presentavano testo riscritto dall’IA.

Poiché il meccanismo su cui si basa la pubblicità programmatica – che utilizza algoritmi per far visualizzare annunci pubblicitari altamente mirati agli utenti su Internet – è così opaco, i brand non sono probabilmente consapevoli del fatto che stanno favorendo e finanziando la proliferazione di questi siti. Per questo motivo, NewsGuard ha deciso di non citarli in questo report.

Ad esempio, all’interno di un articolo pubblicato da LiverPoolDigest.co.uk, che sembrava essere stato riscritto a partire da un pezzo del Guardian utilizzando l’IA, gli analisti di NewsGuard hanno visualizzato annunci programmatici di due importanti società di servizi finanziari, un’azienda di forniture per uffici, una compagnia aerea, un’azienda di software multimiliardaria, un rivenditore di elettrodomestici di alto livello, una catena alberghiera statunitense, una grande banca e un noto rivenditore di materassi.

Allo stesso modo, NewsGuard ha trovato annunci programmatici di un’azienda di software di alto profilo, un popolare servizio di streaming, un rivenditore di elettrodomestici di alto livello, un noto rivenditore di materassi, un’importante società di noleggio auto e una nota società di servizi finanziari all’interno di un articolo pubblicato da WhatsNew2Day.com, che sembrava essere stato riscritto utilizzando l’IA da The Conversation, sito che pubblica contenuti accademici. In un’email a NewsGuard, Cath Kaylor, assistente amministrativa di The Conversation Australia, ha dichiarato che WhatsNew2Day.com “non ha rispettato le nostre linee guida sulla ripubblicazione e pertanto ci metteremo in contatto con loro”

NewsGuard ha inviato un’email a 12 delle 55 grandi aziende le cui pubblicità comparivano su quei siti web, chiedendo se fossero consapevoli della cosa. Solo un’azienda ha risposto. Il portavoce di una società di servizi finanziari ha dichiarato a NewsGuard via email: “L’uso etico dell’IA nel mondo di oggi per i nostri consumatori, le operazioni interne e la reputazione del nostro marchio sono molto importanti per noi. Ci sono organizzazioni giornalistiche affidabili che utilizzano contenuti generati dall’IA in aree emergenti… Una volta che saranno stati definiti standard chiari per i contenuti generati dall’IA, continueremo a studiare strategie di protezione per migliorare i protocolli standard del settore”.

NewsGuard ha anche identificato un sito che utilizza l’intelligenza artificiale per parlare dei problemi dell’intelligenza artificiale. Il già citato WhatsNew2Day.com sembrerebbe aver usato l’IA per riscrivere un articolo di The Verge che illustrava un’indagine di NewsGuard del giugno 2023 sulla presenza di annunci pubblicitari di grandi marchi su siti spam generati dall’IA. L’intelligenza artificiale, tuttavia, non sembra aver notato il paradosso.

A cura di Jack Brewster, Macrina Wang e Coalter Palmer